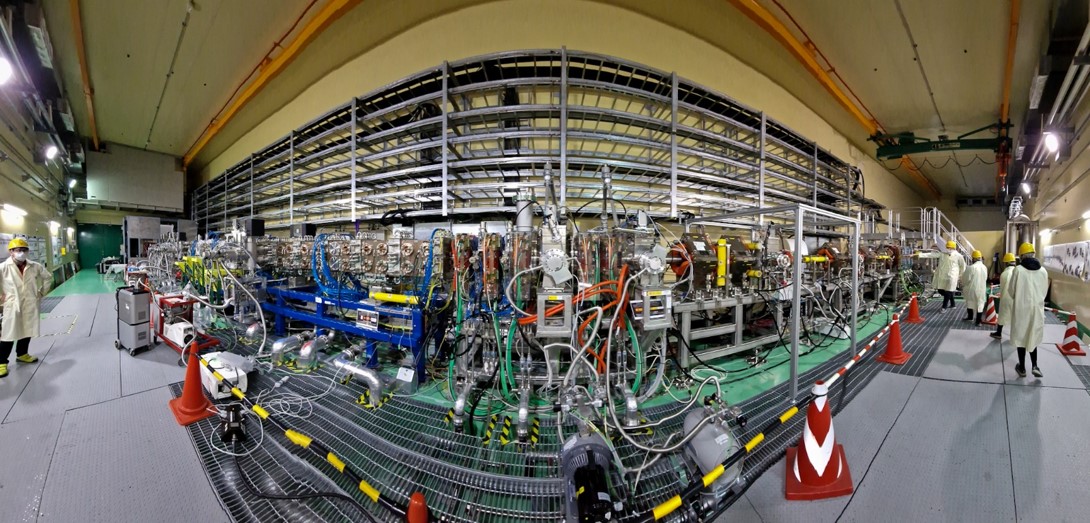

El acelerador de partículas LHC en el CERN produce billones de billones de billones de colisiones de protones cada segundo. Cada uno genera alrededor de un Gigabyte de datos por segundo. ¿Cómo se trata esta montaña de datos ? Instalado en el CERN (Laboratorio Europeo de Física de Partículas), cerca de Ginebra, el LHC es el acelerador de partículas más potente del mundo. A partir de noviembre de 2009, entregó datos de colisiones frontales de protones a una energía de 7 teraelectron voltios (7 TeV), luego 8 TeV, hasta que fue detenido. Este gigantesco instrumento internacional se reiniciará dentro de dos años para prepararse para colisiones aún más violentas, alrededor de 13 TeV. El LHC (Large Hadron Collider) está acompañado de cuatro gigantescos complejos de detección, llamados ALICE, ATLAS, CMS y LHCb, cada uno con sus propias especificidades, que registran los rastros de las colisiones. Cuando el colisionador está en funcionamiento, sus sensores transmiten grandes volúmenes y flujos de datos en forma digital. Como veremos, el almacenamiento, procesamiento y análisis de estos datos requiere una impresionante infraestructura de TI, una de las más potentes del mundo. En el túnel del LHC, dos haces de protones acelerados a una velocidad cercana a la de la luz circulan en direcciones opuestas. Cada segundo, casi 40 millones de paquetes, cada uno de los cuales contiene alrededor de 1011 protones, chocan entre sí. La energía de la colisión protón-protón es tan grande que puede materializarse en todo tipo de partículas, incluyendo los bosones de Higgs. La teoría indica que a priori, un solo bosón de Higgs se produce en promedio cada 1010 colisiones. Además, el bosón de Higgs es inestable y se desintegra muy rápidamente en dos bosones Z, que a su vez se desintegran en leptones detectables (electrones o muones), o en dos fotones, o en un W+ y un W- bosón, etc. Si los detectores fueran perfectos, ATLAS o CMS registrarían un bosón de Higgs cada 1013 colisiones mediante su desintegración en dos fotones o dos Zs. En realidad, la tasa de detección es muy baja. Así, durante los dos años de recolección de datos (2011 y 2012) cuando se produjeron millones de partículas (incluyendo cerca de 500.000 bosones de Higgs, en teoría), ATLAS detectó sólo unos pocos cientos de bosones de Higgs desintegrándose en dos fotones (contra unos pocos miles si el detector hubiera sido perfecto). Los flujos de datos transmitidos por los detectores son considerables. Las colisiones generan miles de partículas secundarias, ya que el paso de una partícula a través de un detector genera pulsos electrónicos a partir de los cuales los físicos pueden determinar su trayectoria e identidad. Los millones de impulsos electrónicos creados por cada colisión son digitalizados por circuitos integrados en los detectores, antes de ser transmitidos por fibras ópticas a las computadoras de adquisición de datos. Se agrupan en forma de archivos binarios de "datos brutos". Cada colisión es, a nivel de cada uno de los cuatro experimentos, un evento cuyo tamaño de datos brutos es del orden de un megabyte. La clasificación inteligente se realiza en menos de un segundo para mantener sólo los eventos potencialmente interesantes. Realizada gracias a circuitos electrónicos previos y luego a clusters de ordenadores y algoritmos especializados, esta clasificación reduce la tasa de adquisición a unos 200 eventos interesantes por segundo. Estos datos sin procesar se graban finalmente a una velocidad equivalente a dos CD por segundo para cada uno de los cuatro experimentos, sabiendo que la capacidad de un CD es de 700 megabytes. Un gigabyte por segundo Los datos brutos son procesados para extraer la información "física" (las características de cada trayectoria, el impulso y la identidad de cada partícula detectada), para luego analizarla. Estos procesos reducen el tamaño de la información en un factor de dos a diez. Generalmente se repiten varias veces al año sobre todos los datos adquiridos desde el inicio, para tener en cuenta el desarrollo continuo de los algoritmos de procesamiento y calibración del detector. Cada uno de los cuatro complejos de detección registra una cifra de colisiones comparable al número de estrellas de la Vía Láctea. El procesamiento de los datos así acumulados es un desafío, tanto por los flujos (del orden de un gigabyte por segundo) como por los volúmenes (varias docenas de petabytes al año, de los cuales un petabyte equivale a 1.000 terabytes, o 1015 bytes). En cualquier momento dado, unos pocos miles de investigadores de todo el mundo solicitan recursos informáticos y de almacenamiento para analizar estos datos. Para hacer frente a este reto, se ha implementado una "tabla de cálculo". Esta cuadrícula agrupa los recursos informáticos y de almacenamiento de muchas máquinas independientes, cada procesador procesa un solo evento. Dado que los eventos son independientes entre sí, hay pocos datos que transferir entre procesadores. La principal ventaja de este sistema es que basta con añadir nuevas entidades para aumentar la capacidad de cálculo de la red, que puede procesar petabytes de datos. La red del LHC se basa en casi 200 centros de computación en todo el mundo. Esta red se clasifica en cuatro niveles, dependiendo de la naturaleza y calidad de los servicios prestados, conectados por enlaces de alta velocidad. Para procesar todos los datos registrados por los experimentos del LHC, los requisitos de capacidad de cálculo alcanzados en 2012 fueron equivalentes a 500.000 ordenadores de sobremesa y más de 200 petabytes de espacio de almacenamiento en disco. Un gigantismo informático a la altura del gigantismo (27 kilómetros de diámetro...) del propio LHC!